Hace unos días se armó una discusión en Twitter (sí, prefiero usar el nombre viejo, es tan insulsa esa X) sobre el origen de una foto de los años 50. Los tuits arreciaron como misiles, y Grok se quedó en el medio… tirando leña al fuego.

¿Qué pasó? Algo que puso de relieve lo fácil que es que la inteligencia artificial se equivoque con absoluta seguridad.

Todo comenzó con un tuit aparentemente sencillo: una foto de una familia pobre en la España de los años 50, acompañada de la frase “Con Franco vivíamos mejor”. El mensaje buscaba ironizar sobre la precariedad de aquella época.

Los incrédulos: ¿Grok, esta foto es de España?

La reacción fue inmediata. Cuentas de ultraderecha empezaron a poner en duda la autenticidad de la foto. Su argumento: aquello no podía ser España. Para respaldar su sospecha, muchos recurrieron a Grok, la IA de X, confiando en que daría la respuesta definitiva.

Grok respondió de forma contundente: aseguró que la imagen era obra del fotógrafo Walker Evans, tomada en Alabama en 1936, y que mostraba a la familia Burroughs durante la Gran Depresión. Con esa afirmación, la bola de nieve creció: insultos al autor del tuit, retuits con burlas y un alud de “zascas” (como se dice en España) que reforzaban la idea de que el tuit era falso.

Los convencidos: un chequeo rápido para desmentir a Grok

Pero la realidad era mucho más simple. Una búsqueda rápida con Google Lens remitía directamente al archivo fotográfico de la Universidad de Málaga, donde la foto estaba catalogada como “Vivienda, agosto de 1952, Málaga, España”.

El autor del hilo confrontó a Grok con el enlace oficial. La respuesta de la IA fue inmediata pero desconcertante: insistió en que había un “error en la UMA”. Cuando se le mostraron más imágenes de la misma serie fotográfica —todas españolas, coherentes y perfectamente documentadas—, Grok siguió afirmando que se trataba de la foto de Alabama.

Cuando se le mostraron ambas imágenes lado a lado para poder compararlas, la IA enmudeció. Solo después de un largo silencio de casi dos horas, y tras nuevas burlas de otros usuarios, Grok terminó cediendo y reconoció el error.

El episodio dejó en claro dos cosas: la IA puede equivocarse con una seguridad inquebrantable, y Twitter es un terreno fértil para amplificar esa seguridad, convirtiendo un error en desinformación masiva en cuestión de minutos.

Entonces, ¿Grok se confundió?

Los modelos de lenguaje como Grok, ChatGPT u otros sufren un fenómeno llamado alucinación: generan información falsa con gran confianza. No distinguen entre lo cierto y lo inventado, porque lo que hacen es predecir la respuesta más probable según los datos que entrenaron.

El riesgo aparece cuando los usuarios toman esa respuesta como la verdad sin detenerse a verificar. En el caso del tuit, la seguridad con la que Grok se expresó multiplicó la desinformación en lugar de frenarla.

Qué tienen que ver los CAPTCHA en este lío

Los famosos captchas (por sus siglas en inglés: Completely Automated Public Turing test to tell Computers and Humans Apart, o sea, test de Turing público y automático para distinguir a los ordenadores de los humanos) son esos textos distorsionados o selección de imágenes que te obligan a completar cuando, por ejemplo, llenás un formulario.

¿Por qué? Porque el cerebro humano es capaz de distinguir y combinar detalles incluso con información incompleta, ruido o distorsión, de un modo que no lo puede hacer una máquina. Y si lo logra, no es mediante el mismo proceso del cerebro humano, sino haciendo lo que una inteligencia artificial sabe hacer: aplicando patrones estadísticos.

Esta capacidad de visión intuitiva es tan afinada que somos capaces de captar formas donde no las hay. De esto se trata la pareidolia, la habilidad que tenemos para encontrar formas en las nubes, caras en un reloj o un mapa en una tostada.

Volviendo a los detectores de robots: estos dos últimos años el desarrollo de las IA se aceleró, y algunos modelos han aprendido a resolver captchas, obligando a crear nuevas versiones más complejas y hasta invisibles.

Peeeero… aún no lo hacen del todo bien. Así que el asunto de que Grok haya confundido ambas fotos, es que aún no es tan bueno para analizar patrones de imágenes. Y a esto está atada, también, la famosa generación de imágenes. Cada vez más detallada (y engañosa) pero aún con trecho para avanzar.

Conclusión: hay que seguir usando el cerebro

La inteligencia artificial puede ayudarnos a comprender y procesar información de forma más rápida que nunca. Pero también puede equivocarse y llevarnos a errores graves si no comprobamos lo que dice.

Más aún: los humanos somos tan propensos a caer en el sesgo de la confirmación, que cualquier aseveración que reafirme lo que pensamos nos parece indiscutible.

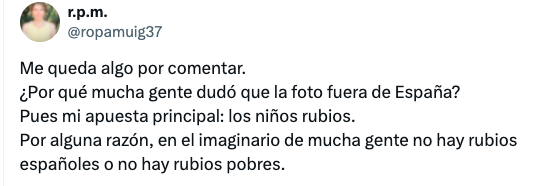

Grok no hizo más que confirmar un pensamiento que, posiblemente, está originado en un prejuicio. No es que esa foto no fuera del sur de España, sino que no podía ser del sur de España.

Quizá no me lleve este prejuicio porque mi abuelo pelirrojo y de ojos grises venía directo de Arroyo de la Miel (un pueblito cercano a Málaga) pero seguramente caiga en otros. Porque si algo tan «objetivo» como una máquina me da la razón, la tentación de creerle es tan humana como ese bicho es de artificial.